2025年11月より応用情報技術者の勉強をしておりましたが、テキストを1巡したので、次はブログにまとめながら学習を進めて行こうという段階に入りました。

応用情報技術者の資格取得を目指す皆さまの力になれればいいなと思い作成しております。

方針としては、基本情報技術者の資格を取った私でも知らない用語が圧倒的に多いということから、暗記を中心に話を進めて行こうと思っております。

暗記を行うにあたり、Ankiアプリの併用を進めます。Ankiアプリのインストール方法・及び使い方については以下のブログを参考にしていただければと思います。

また、暗記をするためのワード選出は、中国製の生成AI「Qwen」を使用しました。理由として、検索ワードが多いため無制限に回数が多く使える生成AIが望ましかったからです。

それではいってみよー!

第1章 基礎理論

集合と論理

| 単語 | 意味 |

|---|---|

| 集合論理 | 集合論理とは、「もののかたまり(集合)」や「正しいかどうか(論理)」を数学的に扱う考え方です。たとえば、「偶数の集合」や「AかつB」といった表現は、コンピュータのプログラムやデータベースの検索条件の基礎になります。集合は中括弧 { } で表し、たとえば {1, 2, 3} は「1, 2, 3からなる集合」です。論理は「真(True)」か「偽(False)」で判断され、これらを組み合わせて複雑な判断をコンピュータにさせることができます。 |

| 部分集合とべき集合 | ある集合Aのすべての要素が集合Bに含まれているとき、「AはBの部分集合」(A ⊆ B)といいます。たとえば、A = {1, 2}、B = {1, 2, 3} なら A ⊆ B です。べき集合(Power Set)は、ある集合のすべての部分集合を集めた集合です。たとえば、集合 {a, b} のべき集合は { {}, {a}, {b}, {a, b} } で、要素数は (nは元の集合の要素数)になります。これはビットフラグやアクセス権限の組み合わせ計算にも使われます。 |

| 差集合と対称差 | 差集合 A − B は、「AにあってBにない要素」の集合です。例:A = {1,2,3}, B = {2,4} なら A − B = {1,3}。対称差(A ⊕ B)は、「AかBのどちらか一方だけに属する要素」です。⊕は直和、または、排他的論理和と読む。式で書くと です。上の例だと、{1,3,4} になります。これはデータの比較や差分バックアップの仕組みに応用されます。 |

| 集合の要素数 | 集合の要素数(基数)は、その集合にいくつの要素があるかを表します。有限集合なら単に数えますが、複数の集合の要素数を扱うときは包除原理を使います。2集合の場合は、 これは、「AまたはBに属する要素数」を正確に求めるための公式です。たとえば、クラスで数学が好きな人が10人、英語が好きな人が8人、両方好きな人が3人なら、少なくともどちらかが好きな人は 人です。 |

| 命題 | 命題とは、「真か偽かが明確に決まる文」のことです。たとえば「2は偶数である」は真の命題、「5は偶数である」は偽の命題です。一方、「がんばれ!」は真偽が決められないので命題ではありません。コンピュータはこの「真(1)・偽(0)」の世界で動いており、すべての判断は命題の組み合わせで成り立っています。 |

| 複合(合成)命題 | 複数の命題を論理演算子(AND, OR, NOTなど)でつなげたものを複合命題と呼びます。たとえば、「AかつB」(A ∧ B)や「AまたはB」(A ∨ B)などです。これらはプログラムのif文やデータベースのWHERE句で使われます。「雨が降っている ∧ 傘を持っていない → 濡れる」のようなルールもこれで表現できます。 |

| 条件文(含意命題) | 「AならばB」(A → B)を含意命題といい、「Aが真ならBも真でなければならない」という意味です。ただし、Aが偽のときはBが何であれ全体は真になります。これは直感とズレやすいですが、たとえば「合格したらプレゼントする」と言った場合、不合格ならプレゼントしなくても約束を破っていません。この性質はプログラムのエラーチェックやテストケース設計で重要です。 |

| 条件文の逆・裏・対偶 | 命題「A → B」に対して、 逆:B → A 裏:¬A → ¬B 対偶:¬B → ¬A があります。この中で、元の命題と対偶は常に真偽が一致します。たとえば「犬なら動物だ」の対偶は「動物でないなら犬ではない」で、どちらも正しいです。逆や裏は成り立たないことが多いので注意が必要です。この考え方は証明やデバッグで有効です。 |

| 論理演算と集合演算 | 論理演算(AND, OR, NOT)と集合演算(∩, ∪, 補集合)は、実は同じ構造を持っています。 A ∧ B ↔ A ∩ B A ∨ B ↔ A ∪ B ¬A ↔ (補集合) この対応により、回路設計やデータベースのクエリ最適化が可能になります。たとえばSQLのWHERE句は、集合演算として解釈することで高速化できます。 |

| 演算則を用いた簡略化 | 論理式や集合式は、交換法則・分配法則・ド・モルガンの法則などを用いて簡単にすることができます。たとえば、ド・モルガンの法則、 これは「AかつBでない」=「Aでない、またはBでない」と読み替えられる、非常に強力なルールです。プログラムの条件分岐を短くしたり、論理回路の素子数を減らすのに使われます。 |

| カルノー図を用いた簡略化 | カルノー図は、真理値表を視覚的に整理して論理式を簡単にする図です。たとえば3変数(A, B, C)なら8マスのグリッドに1(真)を埋め、隣り合う1をまとめて共通項を見つけます。これにより、ANDやORの数を減らし、回路を小型化できます。2026年現在でも、FPGAや組み込みシステムの低レイテンシ設計で活用されています。特に人手による最適化が必要な小規模回路では、ソフトウェアより直感的で効果的です。 |

情報理論と符号化

| 単語 | 意味 |

|---|---|

| 情報量(I) | 情報量は、「ある出来事が起こったときに、どれだけ『驚き』があるか」を数値化したものです。たとえば、「明日は雨が降る」と言われても、いつも雨が降る地域なら驚きません(情報量小)。しかし砂漠で「明日雪が降る」と言われたら大驚き(情報量大)。この情報量 は、事象の起こる確率 を使って と定義されます。確率が低いほど情報量は大きくなります。これはデータ圧縮や通信の効率化の基礎となる考え方です。 |

| 情報量の加法性 | 2つの独立な事象AとBが同時に起きたときの情報量は、それぞれの情報量の和になります。つまり、 たとえば、情報量I=-log2p の式を用いると、「コインで表が出る」(、 ビット)と「サイコロで1が出る」(、 ビット)が同時に起きると、情報量は約 3.58 ビットです。この性質は、複数の信号を組み合わせて扱う通信システムや暗号設計で重要です。 |

| 平均情報量(H) | 平均情報量(エントロピー) は、ある情報源(たとえば文字の出現確率)全体の「平均的な驚きの大きさ」を表します。全事象の確率が のとき、 で求められます。たとえば、公平なコインなら ビット、完全に偏った(必ず表)なら ビット。この値は、その情報源を理論的に圧縮できる限界を示しており、JPEGやZIPなどの圧縮アルゴリズムの設計指標になります。 |

| ハフマン符号化 | ハフマン符号化は、「出現頻度が高い記号には短いビット列、低い記号には長いビット列」を割り当てる可変長圧縮方式です。たとえば、文章中で「あ」がよく出るなら「0」、「ん」がめったに出ないなら「11101」とする。これにより、全体のビット数を平均情報量 に近づけられます。2026年現在でも、ZIPやPNG画像フォーマットの一部で使われており、可逆圧縮(元に戻せる)の代表的手法です。 |

| ランレングス符号化 | ランレングス符号化(RLE: Run-Length Encoding)は、「同じデータが連続する長さ」に注目して圧縮する手法です。たとえば、画像で白いピクセルが100個続くなら、「白×100」と記録します。この方式は単純で高速ですが、繰り返しが多いデータ(白黒画像、スクリーンショットなど)でしか効果がありません。現在は、FAXやBMP画像の圧縮、またGPUのテクスチャ圧縮など、特定用途で活用されています。 |

| デジタル符号化 | デジタル符号化とは、音声・画像・文字などのアナログ情報を0と1の列(ビット列)に変換する一連の処理です。たとえば音声では、一定間隔で音の大きさを測定(サンプリング)し、その値を整数に丸める(量子化)してビットに変換します。この過程で「サンプリング周波数」や「ビット深度」が品質を決めます。2026年では、この符号化技術がAI音声認識や高精細映像配信(4K/8K)の基盤となっており、効率と品質のバランスが常に進化しています。 |

オートマトン

| 単語 | 意味 |

|---|---|

| 順序機械 | 順序機械(Sequential Machine)は、「入力に応じて内部状態を持ち、順番に動作する機械」のモデルです。たとえば自動販売機:100円を入れて「ボタンA」を押すと「ジュースが出る」。このとき、100円を入れたという「状態」が記憶されていないと、ボタンを押しても反応できません。つまり、過去の入力履歴が現在の出力に影響するのが順序機械の特徴です。これに対して、過去に依存しないものを「組合せ回路」と呼びます。順序機械はCPUや通信プロトコルの設計の基礎です。 |

| 有限オートマトン | 有限オートマトン(Finite Automaton, FA)は、状態の数が有限な順序機械です。たとえば、「偶数回のAが入力されたらOK」というルールを実現する機械は、「偶数状態」と「奇数状態」の2つだけで動きます。FAには「受理状態」というゴールがあり、入力文字列を処理し終えたときにそこに入っていれば「その文字列はOK」と判断します。FAは正規表現の裏側で動いており、Webフォームの入力チェックやコンパイラの字句解析に使われます。 |

| 正規表現 | 正規表現(Regular Expression)は、「文字列のパターン」を簡潔に書くための記法です。たとえば \d{3}-\d{4} は「3桁の数字+ハイフン+4桁の数字」(例:123-4567)にマッチします。技術的には、正規表現は有限オートマトンと等価です。つまり、どんな正規表現もFAに変換でき、逆も可能。2026年現在、正規表現はログ解析、セキュリティ(攻撃パターン検出)、AI前処理など幅広く利用されています。ただし、再帰や入れ子(例:((())))は表現できない点に注意が必要です。例: ・「 a が偶数個」→ (b*ab*ab*)*( a を2個ずつ挟んで、好きなだけ繰り返し)・電話番号(簡易)→ 0[0-9]-[0-9]{3,4}-[0-9]{4}(例: 03-1234-5678) |

形式言語

| 単語 | 意味 |

|---|---|

| 形式文法と言語処理 | 形式文法とは、ある文字列の集まり(言語)が「正しいかどうか」を判定するためのルールの体系です。たとえばプログラミング言語では、「ifのあとには必ずカッコと条件式が必要」といった決まりがあります。こうしたルールに従って、コンピュータが人間が書いたプログラムを読み解き、実行可能な形に変換する一連の作業を「言語処理」と呼びます。言語処理は、コンパイラやスクリプト言語の実行エンジンの根幹であり、現代のソフトウェア開発に不可欠です。 |

| 文脈自由法(形式文法) | 文脈自由文法は、形式文法の中でも特に重要なタイプで、「ある記号を別の記号列に置き換える」ルールだけで言語を定義します。たとえば、「式」を「式+項」または「項」に置き換えるといった再帰的なルールが書けます。この文法は、丸括弧の対応や関数呼び出しの入れ子など、階層的な構造を扱えるため、C言語やPythonなどほぼすべてのプログラミング言語の文法記述に採用されています。2026年現在も、コンパイラ構築の理論的基盤として広く使われています。 |

| 言語処理 | 言語処理は、ソースコードをコンピュータが実行できる形に変換するプロセス全体を指します。このプロセスは、まず文字列を単語や記号に分ける「字句解析」、次にその並びが文法に合っているかを調べる「構文解析」、そして意味の整合性を確認する「意味解析」、最後に機械語や中間コードを生成する「コード生成」の段階で進みます。たとえば「x = a + b;」という1行も、コンピュータにとってはこの一連の変換を経て初めて「理解」されます。 |

| 字句解析 | 字句解析は、プログラムの文字列を「意味のある最小単位」に切り分ける最初のステップです。たとえば「while (x < 10)」は、「while」(予約語)、「(」(開き括弧)、「x」(変数名)、「<」(比較演算子)、「10」(数値)、「)」(閉じ括弧)といったトークンに分解されます。この処理は、正規表現と有限オートマトンを使って高速に実行され、後の解析の正確性を左右するため、言語処理の重要な入口です。 |

| 構文解析 | 構文解析は、字句解析で得られたトークンの並びが、文法に従っているかを検査し、その構造を明確にする処理です。たとえば「2 + 3 * 4」は、掛け算が足し算より優先されるというルールに従って、「3と4を先に掛けて、その結果に2を足す」という構造に解釈されます。この処理は、構文木と呼ばれる階層構造を生成し、コンパイラがその後の最適化や実行コード生成を行うための土台となります。 |

| BNF記法 | BNF記法(バッカス・ナウア記法)は、文法を厳密かつ簡潔に記述するための記法です。「左辺 ::= 右辺」という形式で、左辺の記号が右辺の記号列に置き換えられることを示します。たとえば「式 ::= 項 | 式 "+" 項」と書けば、「式は項そのものか、式にプラスと項をつなげたもの」と定義できます。この記法は、プログラミング言語の公式仕様書で広く使われ、開発者やコンパイラ作成者が共通の理解を持つための共通言語となっています。 |

| BNF記法(再帰) | BNFの強みは、自分自身を右辺に含む再帰的な定義が可能だという点です。たとえば「リスト ::= 要素 | リスト "," 要素」と定義すれば、1つ、2つ、100個と、任意の長さのリストを表現できます。この再帰性により、入れ子になったif文や、関数呼び出しの連続といった、現実のプログラムによくある構造を自然に記述できます。ただし、再帰が深すぎると実行時にメモリ不足になるため、実装では工夫が必要です。 |

| 構文木 | 構文木は、プログラムの構造を木の形で表現したものです。根に全体の式が、枝に部分式が、葉に具体的なトークン(数値や変数名など)が配置されます。たとえば「(a + b) * c」なら、根が「*」で、左の子が「+」(その下にaとb)、右の子がcという形になります。この木を見れば、計算の順序やプログラムの階層構造が一目でわかり、コンパイラはこれに基づいて効率的なコードを生成します。 |

| 構文木の利用 | 構文木は、単にプログラムを実行するだけでなく、コードの変換・最適化・分析にも広く使われます。たとえば、コンパイラは「x * 2」を「xを1ビット左シフト」という高速な命令に置き換える際に構文木を使います。また、AIがバグを検出したり、自然言語で書かれた要求をプログラムに変換するときにも、内部で構文木が使われています。2026年では、大規模言語モデルが構文的に正しいコードを生成するために、構文木の知識を暗黙に活用するアプローチが注目されています。 |

| 逆ポーランド記法 | 逆ポーランド記法は、演算子を被演算子の後ろに置く記法で、「2 3 +」は「2+3」を意味します。この記法の利点は、カッコを使わなくても計算順序が一意に決まる点です。たとえば「2 3 4 * +」は「2+(3×4)」と解釈され、迷いがありません。この記法は、構文木の後順走査(左→右→親)と一致し、スタックを使った簡単な計算で実行できます。そのため、中間コードや一部の電卓、Forth言語などの実装で使われ続けています。 |

| 正規表現の短縮 | 正規表現の短縮とは、同じ文字列の集合を表すよりシンプルで効率的な正規表現を導き出すことです。たとえば「aα」は「αa」と書け、意味は同じですが読みやすくなります。理論的には、正規表現の最小化は計算量的に難しい問題ですが、実用上は共通部分をまとめたり、不要な繰り返しを削除することで、処理速度や可読性を向上させます。2026年では、セキュリティシステムやログ解析エンジンが大量の正規表現を高速に処理するために、この最適化が重要視されています。 |

グラフ理論

| 単語 | 意味 |

|---|---|

| 有向グラフ | 有向グラフは、点(頂点)と、矢印のように向きを持った線(有向辺)で構成される図です。たとえば、「AがBをフォローしている」や「タスクXが終わってからタスクYを開始できる」といった、一方向の関係を表すのに適しています。Webページ間のリンクも有向グラフで、これが検索エンジンのPageRankアルゴリズミックな評価の基礎となっています。 |

| 無向グラフ | 無向グラフは、頂点どうしを向きのない線(辺)で結んだもので、「AとBは友達だ」のように相互関係を表します。辺に方向がないため、A−BとB−Aは同じ意味です。このようなグラフは、道路網や電力網、あるいは分子の結合構造など、対称的なつながりを持つシステムのモデルとして広く使われています。 |

| サイクリックグラフ | サイクリックグラフとは、閉じたループ(閉路)が存在するグラフです。有向ならA→B→C→A、無向なら三角形のように一周できる経路があることを意味します。逆に、閉路がないグラフは「非巡回グラフ」と呼ばれ、特に有向非巡回グラフ(DAG)は、プロジェクトのタスク順序やデータ処理の依存関係を表すのに最適です。2026年では、AIの計算グラフやブロックチェーンのDAG型台帳もこの構造を採用しています。 |

| 多重グラフ | 多重グラフは、同じ2つの頂点の間に複数の辺が存在してもよいグラフです。たとえば、東京と大阪の間に「新幹線」「飛行機」「高速バス」という3種類の移動手段がある場合、それぞれを別々の辺として扱えます。これにより、現実世界の複雑な関係をより忠実にモデル化でき、交通システムや通信ネットワークの冗長設計に役立ちます。 |

| 完全グラフ | 完全グラフは、すべての頂点が互いに直接つながっているグラフです。頂点がn個あるとき、辺の数はn(n−1)/2本になります(無向の場合)。たとえば4人全員がお互いに握手した回数を考えると、まさにこの構造です。現実では辺が多すぎて非効率なため、完全グラフそのものより、その性質を部分的に活用するケースが多いです。 |

| 2部グラフ | 2部グラフは、頂点を2つのグループに分け、辺が異なるグループ間だけに存在するグラフです。たとえば「学生」と「講義」の関係や、「商品」と「購入者」の推薦システムなどがこれに該当します。同じグループ内では辺がありません。この構造は、マッチング問題(例:人材と職務の最適割り当て)のアルゴリズムで広く使われ、AIによる人材配置や広告配信の基盤となっています。 |

| オイラーグラフ | オイラーグラフは、すべての辺をちょうど1回ずつ通って一筆書きできるグラフです。無向グラフでは、すべての頂点の次数(つながっている辺の数)が偶数であればオイラーグラフになります。この性質は、郵便配達やドローンによる点検ルートの最適化に応用され、効率的な巡回経路設計の理論的根拠を提供します。 |

| ハミルトングラフ | ハミルトングラフは、すべての頂点をちょうど1回ずつ通って戻ってくる経路(ハミルトン閉路)が存在するグラフです。これは「巡回セールスマン問題」の基礎となる概念で、オイラー路が「辺」に注目するのに対し、ハミルトン路は「頂点」に注目します。この問題は計算が非常に難しく、2026年現在でも完全な最適解を求めるのは現実的でないため、AIやヒューリスティック手法による近似解が実用されています。 |

| 正則グラフ | 正則(せいそく)グラフは、すべての頂点の次数が同じであるグラフです。たとえば各頂点が3本の辺を持つなら「3-正則グラフ」と呼びます。立方体の頂点と辺の関係や、特定の通信ネットワークの構成がこれにあたります。正則性はネットワーク全体の負荷を均等に保つため、P2Pネットワークや分散システムの設計で意図的に採用されることがあります。 |

| 行列表現 | グラフをプログラムで扱うには、図ではなく数値データにする必要があります。その代表が隣接行列で、n個の頂点があるグラフならn×nの正方形の配列を使います。頂点iからjに辺があれば1、なければ0を格納します。有向グラフなら非対称、無向なら対称になります。この表現は、グラフの性質を線形代数の手法で分析できるため、影響力分析や検索順位計算に広く使われています。 |

| リスト表現 | 隣接リストは、各頂点について「つながっている頂点のリスト」を保持する表現方法です。たとえば頂点AがBとCにつながっていれば、Aには[B, C]というリストを持たせます。辺が少ない大規模グラフでは、隣接行列よりメモリ効率がよく、SNSやWebのような巨大ネットワークではこれが主流です。2026年でも、グラフデータベースや知識グラフは基本的にこの形式で実装されています。 |

| 行列表現の応用例 | 隣接行列を累乗することで、複数ステップで到達可能な経路の数を計算できます。たとえば行列Aの2乗A2の(i, j)成分は、頂点iからjへちょうど2辺で到達する経路の数を表します。この性質は、感染症の拡散シミュレーションや、SNSでの情報伝播の範囲予測に使われ、グラフニューラルネットワーク(GNN)の設計にも応用されています。 |

| ダイクストラ法 | ダイクストラ法は、1つの頂点から他のすべての頂点への最短経路を求めるアルゴリズムです。辺に距離や時間などの重みがあるグラフで使えます。基本的な考え方は、「現在最も近い未確定の頂点を確定し、そこから他の頂点への距離を更新する」という貪欲法です。2026年では、カーナビの経路探索、物流配送の最適化、クラウドネットワークの遅延最小化など、リアルタイム性が求められる場面で広く使われています。 |

確率と統計

| 単語 | 意味 |

|---|---|

| 場合の数 | 場合の数とは、ある事象が起こりうるすべてのパターンの数を数えることです。たとえばコインを2回投げたとき、表裏の出方は(表,表)、(表,裏)、(裏,表)、(裏,裏)の4通りあります。このような数え上げは、確率を求める第一歩であり、パスワードの総数やゲームの勝敗パターンの計算などに使われます。 |

| 組合せ | 組合せは、「n個のものからr個を選ぶときの選び方の数」で、順番を区別しません。たとえば5人から3人を選ぶのは、順番が違っても同じチームなら1通りです。この数は で求められます。組合せは、宝くじの当選確率や、機械学習での特徴量選択など、多くの分野で基本的な道具となっています。 |

| 確率の定義 | 確率とは、ある事象が起きる可能性の度合いを0から1の数値で表したものです。すべての結果が同様に確からしいとき、確率は「起こる場合の数 ÷ 全体の場合の数」で求められます。たとえばサイコロで1が出る確率は1/6です。2026年では、この古典的定義に加えて、頻度的確率(長期的な割合)や主観的確率(信念の度合い)もAIや意思決定支援で使われています。 |

| 原因の確率 | 原因の確率とは、「結果が観測されたとき、その原因がどれだったか」を推定する確率で、ベイズの定理を使って求めます。たとえば「ある検査で陽性が出たとき、本当に病気にかかっている確率は?」という問いです。式は です。この考え方は、スパムメール判定や医療診断AIの根幹となっており、2026年では生成AIの信頼性評価にも応用されています。 |

| マルコフ過程 | マルコフ過程は、「次の状態が、現在の状態だけに依存し、過去には依存しない」という性質を持つ確率過程です。たとえば天気予測で「今日が晴れなら明日の天気の確率が決まるが、一昨日の天気は関係ない」と仮定するモデルです。この性質(マルコフ性)により、計算が非常に簡単になり、音声認識、自然言語処理、株価予測などに広く使われています。 |

| モンテカルロ法 | モンテカルロ法は、乱数をたくさん使って複雑な問題を近似的に解く手法です。たとえば円の面積を求めるとき、正方形の中にランダムに点を打ち、「円の中に入った点の割合」から円周率を推定できます。この方法は、解析的に解けない積分や、AIの強化学習における行動評価、金融工学のリスク計算など、2026年でも幅広い分野で活用されています。 |

| 代表値 | 代表値とは、データの「 typical 」な値を示す数値で、主に平均値、中央値、最頻値があります。平均値は全データの合計を個数で割った値、中央値はデータを並べたときの真ん中の値、最頻値は最も多く出現する値です。たとえば所得の分布では、平均値が一部の高所得者で引き上げられるため、中央値が実態をよりよく表すことがあります。 |

| 散布度 | 散布度は、データがどれだけばらついているかを示す指標です。代表的なものに「範囲(最大−最小)」「分散」「標準偏差」があります。たとえば2つのクラスのテスト平均が同じでも、分散が大きいクラスは成績の差が激しいことを意味します。このばらつきの理解は、品質管理やリスク評価の基礎となります。 |

| 平均値と分散・標準偏差の性質 | 平均値はデータの重心、分散は各データが平均からどれだけ離れているかの2乗平均、標準偏差はその平方根です。分散の式は 標準偏差は (シグマ) で表されます。μ(ミュー)は平均です。重要な性質として、「データに定数aを足すと平均がa増えるが分散は変わらない」「定数bを掛けると平均はb倍、分散はb²倍になる」があります。これらはデータの正規化やスケーリングで頻繁に使われます。 |

| 確率分布の種類 | 確率分布には、離散型(サイコロの目、コインの表裏)と連続型(身長、時間)があります。代表的な離散分布に二項分布(成功/失敗の繰り返し)、ポアソン分布(単位時間内の発生回数)、連続分布に正規分布、指数分布(待ち時間)などがあります。それぞれの現象に適した分布を選ぶことで、現実の不確実性をモデル化できます。 |

| 正規分布の性質 | 正規分布は、釣り鐘型の連続確率分布で、平均μ(ミュー)と標準偏差σ(シグマ)で完全に決まります。重要な性質として、「平均±1σの範囲に約68%、±2σに約95%、±3σに約99.7%のデータが入る」という経験則があります。この分布は、測定誤差、テスト得点、自然現象の多くをよく近似し、統計的推測の中心的な役割を果たしています。 |

| 標準平均と標本合計の分布 | 母集団から無作為にn個の標本を取ったとき、その標本平均の分布は、nが大きいほど正規分布に近づきます(中心極限定理)。平均は母平均と同じ、分散は母分散をnで割った値になります。標本合計は、標本平均×nなので、その分布も正規分布に近く、平均はn×母平均、分散はn×母分散です。この性質は、世論調査や品質検査の信頼区間計算の根拠です。 |

| 正規分布の加法性 | 正規分布に従う2つの独立な確率変数XとYがあるとき、その和X+Yも正規分布に従います。具体的には、標準偏差σ(シグマ)、平均μ(ミュー)とすると、X~N(μ₁, σ₁2)、Y~N(μ₂, σ₂2)なら、X+Y~N(μ₁+μ₂, σ₁2+σ₂2)です。この加法性は、複数の誤差が重なる測定や、ポートフォリオのリスク評価など、2026年でも統計モデルの構築で重要な役割を果たしています。 |

回帰分析

| 単語 | 意味 |

|---|---|

| 単回帰分析 | 単回帰分析は、1つの説明変数(入力)を使って目的変数(出力)を予測する手法です。たとえば「勉強時間」から「テストの点数」を予測するモデルです。この関係を直線 で表し、a(傾き)とb(切片)をデータから求めます。これにより、「勉強時間が1時間増えると、点数は平均で何点上がるか」が定量的にわかります。 |

| 線形回帰 | 線形回帰は、目的変数と説明変数の関係を直線(または超平面)で近似する回帰の総称です。単回帰は1変数、重回帰は複数変数の線形回帰です。線形とは「変数の1次式」を意味し、 の形です。シンプルながら解釈しやすく、AIの初期モデルや経済分析で広く使われています。 |

| 最小二乗法 | 最小二乗法は、回帰直線の係数を求めるための代表的な方法で、実際のデータ点と直線の縦方向のズレ(残差)を最小にするように直線を決めます。具体的には、残差の2乗和 を最小にするaとbを求めます。この方法は計算が安定しており、2026年でも機械学習の基本アルゴリズムとして組み込まれています。 |

| 相関係数 | 相関係数は、2つの変数の直線的な関係の強さと向きを−1から1の数値で表したものです。1に近いほど正の直線関係(一方が増えるともう一方も増える)、−1に近いほど負の関係、0に近いほど直線関係がないことを示します。ただし「相関がある≠因果がある」ことに注意が必要で、これはデータ分析の基本原則です。 |

| 重回帰分析 | 重回帰分析は、複数の説明変数を使って目的変数を予測する手法です。たとえば「勉強時間」「睡眠時間」「過去の点数」から「今回のテスト点数」を予測するモデルです。式は で、各wはその変数の影響力を示します。これは、マーケティング分析や医療リスク予測で広く使われています。 |

| 偏相関係数 | 偏相関係数は、他の変数の影響を除いた2変数間の相関を示す指標です。たとえば「勉強時間」と「点数」の相関を調べるとき、「睡眠時間」の影響を統計的に取り除いて計算します。これにより、見かけ上の相関(擬似相関)を排除し、より本質的な関係を把握できます。2026年では、因果推論AIの前処理で重要な役割を果たしています。 |

| ロジスティック回帰分析 | ロジスティック回帰は、目的変数が2値(例:合格/不合格、スパム/通常メール)のときに使う回帰モデルです。直線ではなく、S字型のシグモイド関数 を使って「確率」を予測します。出力は0から1の確率値で、これを0.5以上なら1、未満なら0と判定します。これは、医療診断や詐欺検出など、分類問題の基本アルゴリズムです。 |

数値計算

| 単語 | 意味 |

|---|---|

| 二分法 | 二分法は、連続関数f(x)の解(f(x)=0となるx)を求める数値的手法です。まずf(a)とf(b)が異符号(片方が正、片方が負)となる区間[a, b]を見つけ、その中点cでf(c)を計算。f(c)の符号に応じて、解が含まれる半分の区間を選び、これを繰り返します。区間がどんどん狭くなり、解に近づきます。シンプルで確実ですが、収束はやや遅めです。 |

| ニュートン法 | ニュートン法は、関数の接線を使って高速に解を求める手法です。現在の推定値xₙから、f(xₙ)の接線を引き、そのx切片を次の推定値xₙ₊₁とします。式は です。収束が非常に速いのが特徴ですが、導関数が必要で、初期値が悪いと発散することもあります。2026年では、機械学訳や最適化アルゴリズムの内部で使われています。 |

| 数値積分 | 数値積分は、関数のグラフとx軸の間の面積(定積分)を近似的に求める手法です。代表的な方法に「台形公式」や「シンプソンの公式」があります。たとえば台形公式では、区間を細かく分け、各区間を台形とみなして面積を合計します。解析的に積分できない関数(例:e^(−x2))でも、これで高精度な値が得られ、科学技術計算やAIの確率密度計算で使われます。 |

| 誤差 | 数値計算では、計算結果と真の値のズレ(誤差)が避けられません。誤差には、モデル自体の近似による「モデル誤差」、有限の桁数で数値を表現する「丸め誤差」、アルゴリズムの近似による「打切り誤差」などがあります。これらの誤差を理解し、制御することが、信頼性の高い計算を行う上で不可欠です。 |

| 絶対誤差 | 絶対誤差は、「計算値と真の値の差の絶対値」で、単純なズレの大きさを示します。たとえば真の値が3.1416、計算値が3.14なら、絶対誤差は0.0016です。この指標は直感的ですが、値のスケールが大きいときには相対的なズレを見落とす可能性があるため、他の指標と併用されます。 |

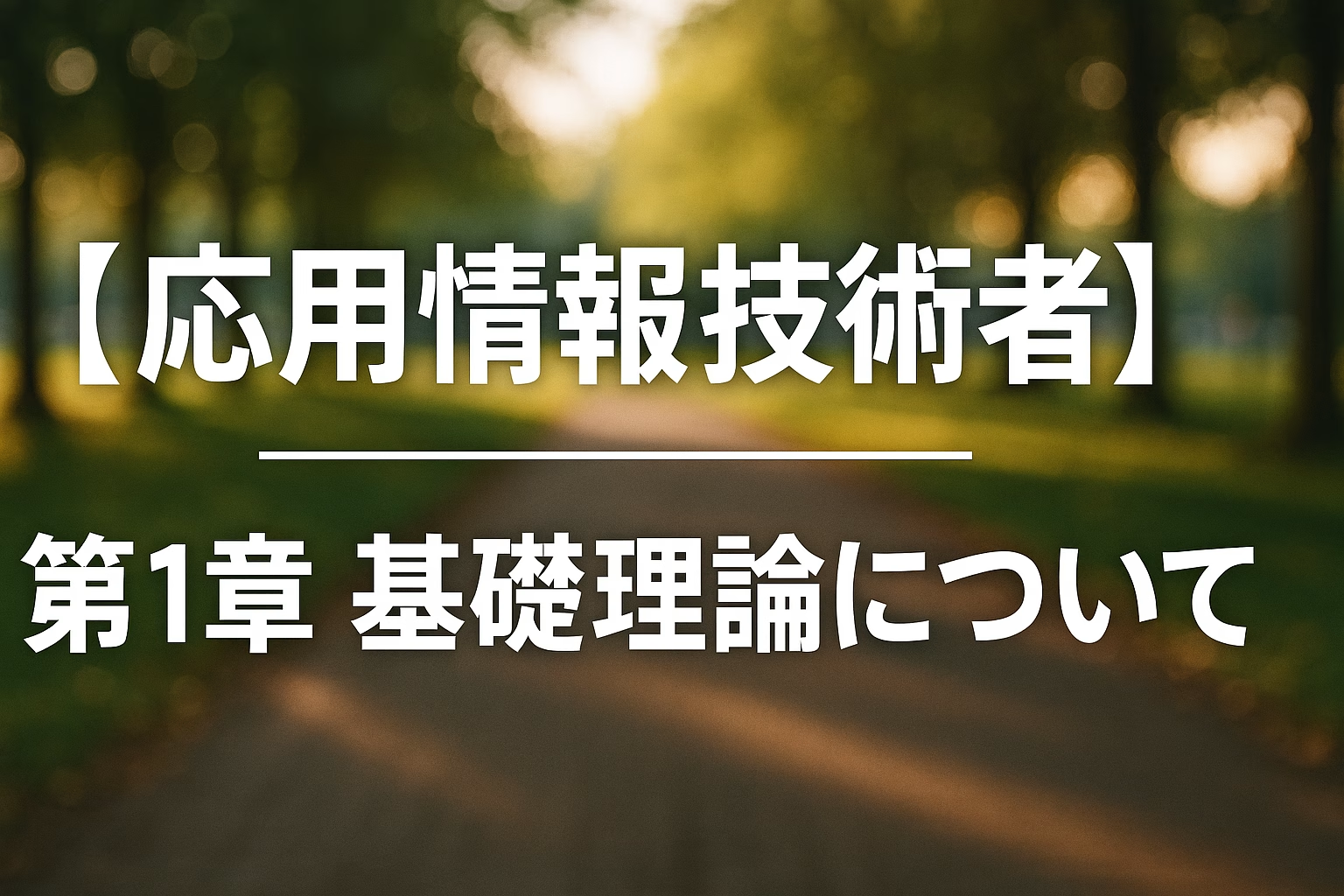

| 相対誤差 | 相対誤差は、「絶対誤差を真の値で割ったもの」で、誤差の割合を示します。式は です。たとえば1000の値で1の誤差は0.1%、1の値で1の誤差は100%と、同じ絶対誤差でも重要度が異なります。相対誤差は、スケールの異なるデータを比較するときに特に有効です。 |

| 連立一次方程式の行列による表現 | 連立一次方程式は、行列とベクトルの積で簡潔に表せます。たとえば は、行列A、未知数ベクトルx、定数ベクトルbを使って と書けます。この表現により、コンピュータで大量の変数を同時に扱うことが可能になり、機械学習や物理シミュレーションの基盤となっています。 |

| 単位行列と逆行列 | 単位行列Iは、対角成分が1、他が0の正方行列で、どんな行列Aに対しても となる性質を持ちます。逆行列A⁻¹は、 を満たす行列で、連立方程式 の解を と直接求められるようにします。ただし、すべての行列に逆行列が存在するわけではなく、行列が「正則」である必要があります。 正則であるとき、 Ax=b A-1(Ax)=A-1b (A-1A)x=A-1b Ix=A-1b x=A-1b |

| 掃き出し法 | 掃き出し法(ガウスの消去法)は、連立一次方程式を効率的に解くアルゴリズムです。行列の行基本変形(行の入れ替え、定数倍、他の行の加算)を使って、係数行列を上三角行列に変形し、最後に後退代入で解を求めます。これは、コンピュータグラフィックスや回帰分析の正規方程式の解法など、2026年でも多くの数値計算ライブラリの内部で使われています。 |

AI(人工知能)

| 単語 | 意味 |

|---|---|

| 機械学習 | 機械学習は、明示的なプログラムを書かずに、データからコンピュータに学習させる技術です。大量の入力と出力のペアを与えることで、コンピュータが「ルール」や「パターン」を自動的に見つけ出し、未知のデータに対しても予測や判断ができるようになります。2026年では、画像認識、音声アシスタント、自動運転など、ほぼすべてのAIサービスの根幹を支えています。 |

| 教師あり学習 | 教師あり学習は、正解ラベル付きのデータを使ってモデルを学習させる方法です。たとえば、「この画像は猫」「この文章はポジティブ」といったペアを用いて、モデルが入力から正解を予測できるように調整します。代表的なタスクに「分類」(カテゴリ予測)と「回帰」(数値予測)があり、ロジスティック回帰やニューラルネットワークがこの枠組みで使われます。 |

| 教師なし学習 | 教師なし学習は、ラベルなしのデータだけを使って、その中に隠れた構造やパターンを見つける手法です。代表的なものに「クラスタリング」(似たデータをグループ化)と「次元削減」(データの本質的な特徴を抽出)があります。たとえば顧客データをクラスタリングしてマーケティング戦略を立てる、といった用途で使われ、2026年では異常検出や推薦システムの前処理で重要です。 |

| 強化学習 | 強化学習は、エージェントが試行錯誤を通じて報酬を最大化する行動戦略を学ぶ手法です。たとえば囲碁AIは、勝てば報酬、負ければ罰則を受け、何百万回の対局を通じて最適な手を学びます。この方法は、ロボット制御やゲームAI、資源配分の最適化など、環境とのインタラクションが必要なタスクで活用されています。 |

| ディープラーニング | ディープラーニングは、多層のニューラルネットワークを使って特徴を自動的に抽出・学習する機械学習の一分野です。従来の機械学習では人間が特徴量(例:画像の輪郭)を設計する必要がありましたが、ディープラーニングは生のデータ(例:ピクセル値)から特徴を自動で学びます。2026年では、生成AI(画像・文章生成)、医療画像診断、リアルタイム翻訳など、最先端のAIアプリケーションの中心技術となっています。 |

みんなで使おう!Ankiアプリで暗記しよう

Ankiアプリの記事と、現時点までに作成されたAnkiアプリのデータへのリンクを掲載しております。どうぞご利用ください。

本日分までのAnkiアプリデータはこちら。

パスワードは「shirakawa」です。お間違えのないように。

参考図書

応用情報技術者の資格勉強をするにあたり、科目A対策として以下の教科書を使用しています。できれば、こちらもAnkiアプリと併用しながらご利用いただければと思います。暗記した内容とのつながりが理解できるようになるのでオススメですよ。

合わせて読みたい

最後に

いかがでしたでしょうか?

この教科書で学ぶにあたり、基本情報技術者と応用情報技術者の差を思い知りました。応用は基本に比べて覚えることが更に多い!!

基本情報技術者と応用情報技術者の違いを、参考書を1巡した私が思った感じで述べますと、基本情報技術者は言葉をとりあえず覚えましょうという感じで、応用情報技術者は覚えたことで何ができるかを考えましょうといった感想を持ちました。

応用は基本を更に深堀りして、完全に暗記していかないと対応が難しいということです。

勉強をはじめた皆さん。是非、私と一緒に頑張りましょう!

ではでは、参考までに

コメント